Immagina di poter migliorare drasticamente le risposte della tua intelligenza artificiale preferita con un trucco così semplice da sembrare quasi assurdo: ripetere la domanda due volte. Sembra troppo bello per essere vero, eppure è esattamente quello che hanno dimostrato i ricercatori di Google in un paper pubblicato a dicembre 2025.

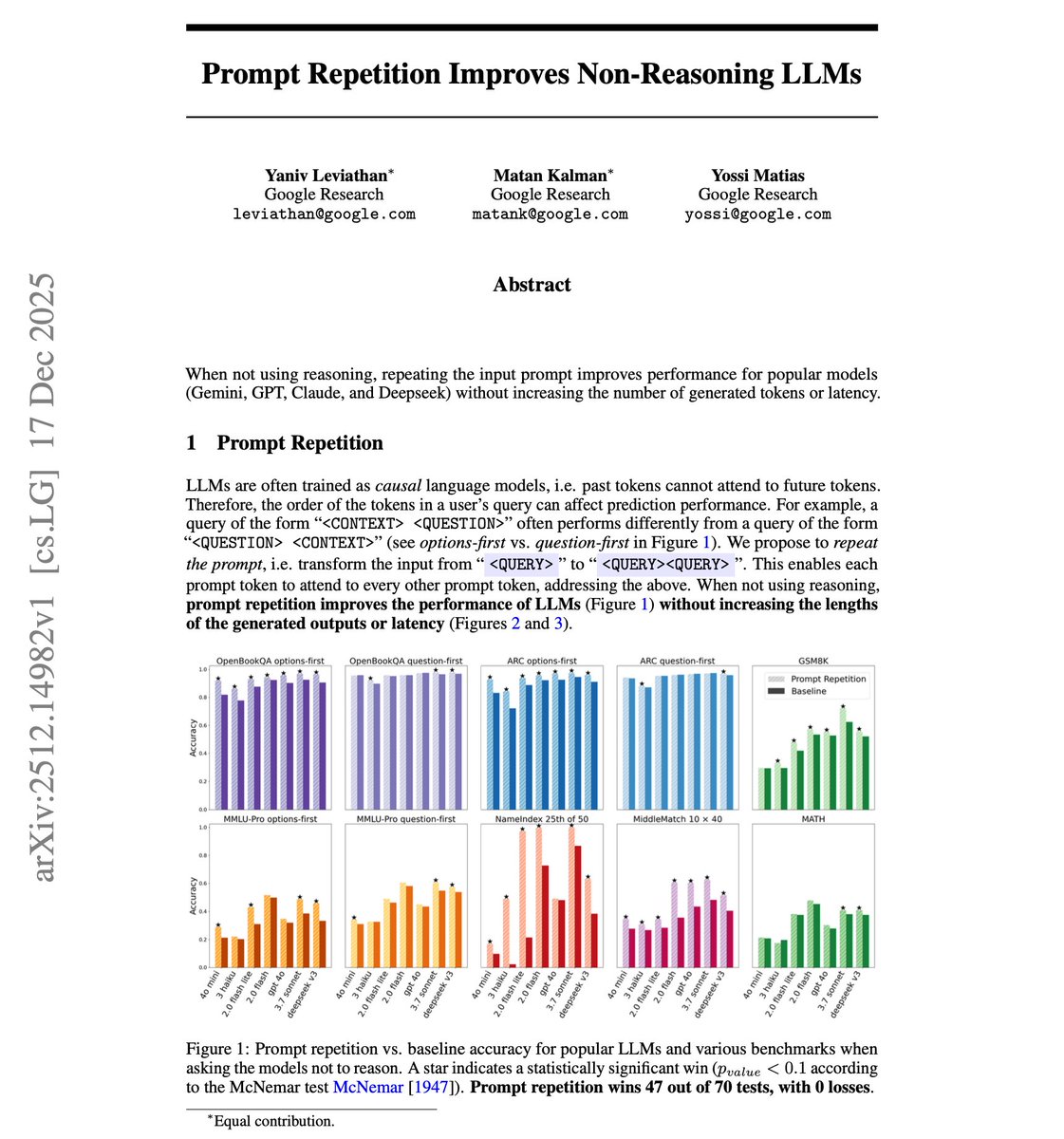

La tecnica si chiama Prompt Repetition e i risultati sono impressionanti: 47 vittorie su 70 test, zero sconfitte. In alcuni casi specifici, l'accuratezza è salita dal 21% al 97%. E la cosa più sorprendente? Non costa nulla in termini di tempo di risposta o token generati.

Cos'è la Prompt Repetition e Perché Funziona

La Prompt Repetition è una tecnica di prompting che consiste nel trasformare il tuo input da "DOMANDA" a "DOMANDA DOMANDA". In pratica, scrivi la stessa richiesta due volte di seguito prima di inviarla all'intelligenza artificiale.

Ma perché una cosa così banale dovrebbe funzionare? La risposta sta nell'architettura dei modelli linguistici. Gli LLM come ChatGPT, Claude e Gemini sono addestrati come modelli "causali", ovvero elaborano il testo rigorosamente da sinistra a destra. Quando il modello sta processando il quinto token della tua frase, può "vedere" i token da 1 a 4, ma non ha alcuna conoscenza del token 6 perché non è ancora stato elaborato.

Questo crea un problema: l'ordine delle parole nel tuo prompt può influenzare significativamente la qualità della risposta. Se scrivi "Opzione A, Opzione B, Opzione C - quale scegliere?" il modello elabora le opzioni senza sapere ancora qual è la domanda.

Quando ripeti il prompt, la seconda istanza può "guardare indietro" all'intera query, risolvendo ambiguità e recuperando dettagli specifici che potrebbero essere stati persi in una singola elaborazione. È come dare al modello una seconda possibilità di capire cosa vuoi davvero.

I Risultati della Ricerca Google

I ricercatori Yaniv Leviathan, Matan Kalman e Yossi Matias hanno testato la tecnica su 7 modelli diversi: Gemini 2.0 Flash, Gemini 2.0 Flash Lite, GPT-4o-mini, GPT-4o, Claude 3 Haiku, Claude 3.7 Sonnet e DeepSeek V3. I test sono stati condotti su 7 benchmark differenti, inclusi ARC Challenge, OpenBookQA, GSM8K, MMLU-Pro e MATH.

I risultati parlano chiaro: su 70 combinazioni modello-benchmark testate senza ragionamento esplicito, la Prompt Repetition ha vinto 47 volte con significatività statistica, pareggiato 23 volte e perso zero volte. Il miglioramento più eclatante? Gemini 2.0 Flash-Lite sul benchmark NameIndex è passato dal 21,33% al 97,33% di accuratezza.

Un dettaglio importante: i guadagni erano particolarmente evidenti nei task che richiedono recupero preciso di informazioni dal prompt, come trovare un nome specifico in una lista o identificare elementi in posizioni particolari del testo.

Quando Usare e Quando Non Usare la Prompt Repetition

La tecnica non è una bacchetta magica universale. Funziona meglio per i task non-reasoning, ovvero quando vuoi una risposta diretta senza che il modello debba elaborare ragionamenti complessi passo dopo passo.

Quando i ricercatori hanno combinato la Prompt Repetition con il Chain of Thought (chiedendo al modello di "pensare passo dopo passo"), i vantaggi sono praticamente scomparsi: solo 5 vittorie, 1 sconfitta e 22 pareggi. Il motivo? I modelli che ragionano esplicitamente tendono già a ripetere parti della domanda nel loro processo di elaborazione, rendendo la ripetizione esplicita ridondante.

Usa la Prompt Repetition quando hai bisogno di risposte rapide e dirette: estrazioni di dati, domande a scelta multipla, recupero di informazioni specifiche da un contesto, classificazioni semplici. Evitala quando stai facendo ragionamenti matematici complessi o analisi che richiedono elaborazione step-by-step.

Come Applicare la Tecnica: Esempi Pratici

Applicare la Prompt Repetition è semplicissimo. Ecco alcuni esempi concreti che puoi iniziare a usare subito con Claude, ChatGPT o Gemini.

Esempio 1: Estrazione Dati

Invece di scrivere: "Dal testo seguente, estrai il nome dell'azienda e l'anno di fondazione: [testo]"

Scrivi: "Dal testo seguente, estrai il nome dell'azienda e l'anno di fondazione: [testo] Dal testo seguente, estrai il nome dell'azienda e l'anno di fondazione: [testo]"

Esempio 2: Domande a Scelta Multipla

Invece di: "A) Roma B) Milano C) Napoli D) Torino - Qual è la capitale d'Italia?"

Scrivi: "A) Roma B) Milano C) Napoli D) Torino - Qual è la capitale d'Italia? A) Roma B) Milano C) Napoli D) Torino - Qual è la capitale d'Italia?"

Esempio 3: Classificazione

Invece di: "Classifica questo testo come positivo, negativo o neutro: [recensione]"

Scrivi: "Classifica questo testo come positivo, negativo o neutro: [recensione] Classifica questo testo come positivo, negativo o neutro: [recensione]"

Implicazioni per Sviluppatori e Utenti

Per chi sviluppa applicazioni con le API dei modelli linguistici, questa tecnica offre un miglioramento delle performance praticamente a costo zero. Non aumenta la latenza perché la ripetizione avviene nella fase di "prefill" che è parallelizzabile, e non modifica il formato o la lunghezza delle risposte generate.

C'è però un aspetto interessante legato alla sicurezza. Se ripetere un prompt legittimo migliora la comprensione del modello, potrebbe valere anche per prompt malevoli? I ricercatori suggeriscono che i team di sicurezza dovrebbero testare scenari di "repeated injection attacks". D'altra parte, ripetere i System Prompt di sicurezza potrebbe rafforzare le guardrail del modello a basso costo.

Per chi lavora con l'automazione e l'integrazione AI, come nel caso di web app intelligenti, questa tecnica può essere implementata automaticamente nel preprocessing delle richieste per migliorare l'affidabilità delle risposte senza modifiche strutturali.

Limitazioni e Considerazioni

La tecnica ha alcune limitazioni che è importante conoscere. Per prompt molto lunghi, la ripetizione può aumentare la latenza perché la fase di prefill richiede più tempo. In casi estremi, con contesti già vicini al limite di token del modello, potrebbe essere impossibile applicarla.

I ricercatori hanno anche testato un'alternativa chiamata "Padding", che aggiungeva punti finali per eguagliare la lunghezza del prompt ripetuto senza effettiva ripetizione semantica. Il risultato? Nessun miglioramento. Questo conferma che i guadagni derivano dalla ripetizione semantica del contenuto, non semplicemente dall'aumento della lunghezza dell'input.

Un altro aspetto da considerare: i test sono stati condotti tramite le API ufficiali dei provider, quindi i risultati potrebbero essere influenzati da fattori come ritardi di rete o carichi transitori. I ricercatori stessi suggeriscono di prendere i dati sulla latenza "con un granello di sale".

Il Futuro della Prompt Repetition

I ricercatori di Google hanno già delineato diverse direzioni future per questa ricerca. Tra le più interessanti: il fine-tuning di modelli specificamente con prompt ripetuti, l'addestramento di modelli di ragionamento che imparino a evitare la ripetizione ridondante, e l'esplorazione di varianti come la ripetizione periodica degli ultimi token generati durante la generazione.

Questa ricerca evidenzia un insight fondamentale: i modelli attuali sono ancora profondamente vincolati dalla loro natura unidirezionale. Mentre aspettiamo nuove architetture che potrebbero risolvere questa "cecità causale", workaround semplici ma efficaci come la Prompt Repetition offrono valore immediato per chi lavora con l'intelligenza artificiale oggi.

Leggi anche

- Microsoft Copilot Studio per VS Code: Agenti AI Come Codice

- Claude Cowork Disponibile per Abbonati Pro da 20$/Mese

- TranslateGemma: Google Lancia l'AI Open Source per Traduzioni

- Google Gemini Personal Intelligence: L'AI Che Ti Conosce Davvero

- Google Triplica i Prompt Gemini 3 Thinking: Ecco i Nuovi Limiti

Conclusioni

La Prompt Repetition è una di quelle scoperte che ti fanno chiedere: "Perché non ci abbiamo pensato prima?". È gratuita, facile da implementare, non richiede modifiche tecniche complesse e funziona su tutti i principali modelli AI disponibili oggi.

Se usi regolarmente ChatGPT, Claude o Gemini per il tuo lavoro, prova a ripetere i tuoi prompt nei task dove hai bisogno di risposte dirette e precise. Potresti rimanere sorpreso dai risultati.

Vuoi integrare l'intelligenza artificiale nel tuo business in modo strategico? Contattami per una consulenza su come sfruttare al meglio queste tecnologie per i tuoi progetti digitali.