Vuoi eseguire modelli di intelligenza artificiale come Llama, DeepSeek o Mistral direttamente sulla tua scrivania? Nel 2026 è finalmente possibile grazie a una nuova generazione di PC progettati specificamente per l'AI, capaci di far girare LLM con miliardi di parametri senza dipendere dal cloud.

Ma quale scegliere? In questa guida analizziamo i 5 migliori PC per intelligenza artificiale, ordinati dal più potente (e costoso) al più accessibile. Per ogni macchina indichiamo specifiche, capacità, prezzo e dove acquistarla. E per chi preferisce non investire in hardware, proponiamo le migliori alternative cloud.

Prima di iniziare, un'informazione importante: offriamo servizi di assistenza, configurazione e installazione per questo tipo di hardware AI. Se acquisti una di queste workstation e hai bisogno di supporto per la configurazione, l'installazione dei framework o l'ottimizzazione per i tuoi casi d'uso specifici, contattaci per un preventivo personalizzato.

Cosa Serve per Far Girare LLM in Locale

Prima di scegliere un PC per AI, è fondamentale capire i requisiti hardware. Il fattore più critico è la VRAM (memoria video): più un modello ha parametri, più memoria serve.

Requisiti Minimi per Dimensione Modello

- Modelli 7B parametri: 8-12GB VRAM (quantizzati a 4-bit)

- Modelli 13B parametri: 16-24GB VRAM

- Modelli 70B parametri: 48-80GB VRAM

- Modelli 200B+ parametri: 128GB+ memoria unificata

Oltre alla VRAM, conta la bandwidth di memoria (velocità di trasferimento dati) che influenza direttamente i token al secondo generati. Le architetture con memoria unificata come quelle NVIDIA Grace Blackwell offrono vantaggi significativi per modelli molto grandi.

1. NVIDIA DGX Station (Primavera 2026) – Il Top Assoluto

La NVIDIA DGX Station rappresenta l'apice delle workstation AI desktop. Basata sull'architettura GB300 Grace Blackwell Ultra, offre prestazioni da data center in un formato da scrivania.

Specifiche Tecniche

- Performance: 20 petaFLOP di potenza AI

- Memoria: 784GB unificata

- Modelli supportati: fino a 1 trilione di parametri

- Software: NVIDIA DGX OS con stack AI completo

Per Chi È Indicata

Laboratori di ricerca, grandi aziende e team enterprise che necessitano di eseguire i modelli frontier più avanzati senza dipendere dal cloud. Ideale per fine-tuning di modelli molto grandi e deployment di agenti AI complessi.

Prezzo e Disponibilità

Disponibile da primavera 2026 attraverso partner come ASUS, Boxx, Dell, GIGABYTE, HP, MSI e Supermicro. Prezzo stimato: oltre $50.000 (da confermare al lancio).

2. BIZON G3000 Multi-GPU – Potenza Configurabile

Per chi vuole massima flessibilità nella configurazione, il BIZON G3000 è una workstation modulare che supporta fino a 4 GPU NVIDIA in configurazione custom.

Specifiche Tecniche

- GPU: fino a 4x RTX 5090, RTX 4090, A100 o H100

- CPU: Intel Xeon W o AMD Threadripper

- RAM: fino a 512GB DDR5

- Raffreddamento: a liquido custom per massime prestazioni

- Software: preinstallato con TensorFlow, PyTorch, CUDA, Docker

Per Chi È Indicata

Team di sviluppo AI, data scientist e aziende che vogliono training e fine-tuning locale su modelli medio-grandi. La configurazione multi-GPU permette di scalare gradualmente.

Prezzo e Dove Acquistare

Prezzo: da $3.090 (configurazione base) fino a oltre $30.000 per configurazioni top con 4x H100. Acquistabile su bizon-tech.com. Garanzia fino a 5 anni e supporto tecnico dedicato incluso.

3. NVIDIA DGX Spark – Il Mini Supercomputer da Scrivania

Il NVIDIA DGX Spark è la rivelazione del 2026: un supercomputer AI compatto da 1,2kg che sta nel palmo di una mano ma offre 1 petaFLOP di potenza.

Specifiche Tecniche

- Chip: NVIDIA GB10 Grace Blackwell Superchip

- CPU: 20 core ARM (10x Cortex-X925 + 10x Cortex-A725)

- Memoria: 128GB LPDDR5X unificata

- Storage: 4TB NVMe SSD

- Performance: 1 petaFLOP (FP4)

- Networking: 200GbE ConnectX-7 (collegabile in cluster da 2 unità)

- Consumo: solo 170W

Modelli Supportati

Grazie ai 128GB di memoria unificata, DGX Spark può eseguire modelli fino a 200 miliardi di parametri in locale. Collegando due unità tramite il bundle cluster, si arriva a supportare modelli da 405B come Llama 3.1 405B.

Per Chi È Indicata

Sviluppatori AI, ricercatori, data scientist e startup che vogliono prototipare, fare fine-tuning e inferenza locale con modelli large senza bisogno di un data center. Perfetta anche per chi lavora con dati sensibili e non può usare il cloud.

Prezzo e Dove Acquistare

Prezzo: $3.999 (versione 4TB). Bundle con 2 unità + cavo cluster disponibile. Acquistabile su:

- NVIDIA Store ufficiale

- Amazon

- Micro Center

- Partner: Acer, ASUS, Dell, GIGABYTE, HP, Lenovo, MSI, PNY

4. Workstation RTX 5090/4090 Custom – Il Miglior Rapporto Qualità-Prezzo

Per chi vuole costruire o acquistare una workstation AI senza spendere cifre enterprise, le GPU consumer top di gamma offrono prestazioni eccellenti per la maggior parte dei casi d'uso.

NVIDIA RTX 5090 (2025)

- VRAM: 32GB GDDR7

- Bandwidth: ~1.8 TB/s

- Architettura: Blackwell

- Modelli supportati: fino a 70B parametri (quantizzati)

- Prezzo GPU: circa €2.000-2.500

NVIDIA RTX 4090 (Ancora Ottima)

- VRAM: 24GB GDDR6X

- Bandwidth: 1 TB/s

- Modelli supportati: fino a 70B parametri (con quantizzazione aggressiva)

- Prezzo GPU: circa €1.600-2.000

Configurazione Consigliata

- CPU: AMD Ryzen 9 7950X o Intel Core i9-14900K

- RAM: 64-128GB DDR5

- Storage: 2TB NVMe per modelli + 4TB per dataset

- Alimentatore: 1000W+ certificato

- Raffreddamento: AIO a liquido per CPU, GPU con dissipatore stock

Prezzo Totale Stimato

Sistema completo con RTX 5090: €4.000-5.000. Sistema con RTX 4090: €3.500-4.500. Acquistabile componente per componente o preassemblato da Puget Systems, BIZON o assemblatori locali.

5. Workstation Entry-Level con RTX 3090 – Budget AI

Per chi inizia o ha budget limitato, le RTX 3090 usate rappresentano ancora oggi un'opzione eccellente per l'AI locale.

Specifiche RTX 3090

- VRAM: 24GB GDDR6X (cruciali per AI)

- Bandwidth: 936 GB/s

- Modelli supportati: 7B-13B nativi, 70B con quantizzazione + offloading

- Prezzo GPU usata: €600-900

Configurazione Budget

- CPU: AMD Ryzen 7 7700X o Intel Core i7-13700K

- RAM: 64GB DDR5 (minimo 32GB)

- Storage: 1TB NVMe

- Alimentatore: 850W

Prezzo Totale

Sistema completo con RTX 3090 usata: €1.500-2.000. È il miglior punto di ingresso per chi vuole sperimentare con AI locale senza investimenti importanti.

Tabella Comparativa

Ecco un riepilogo delle 5 opzioni ordinate per prezzo decrescente:

- DGX Station: 784GB RAM, 20 petaFLOP, modelli 1T, prezzo €50.000+

- BIZON G3000 4xH100: 320GB VRAM, training distribuito, prezzo €25.000-35.000

- DGX Spark: 128GB unificata, 1 petaFLOP, modelli 200B, prezzo €3.700

- Custom RTX 5090: 32GB VRAM, modelli 70B, prezzo €4.000-5.000

- Custom RTX 3090: 24GB VRAM, modelli 13B-70B, prezzo €1.500-2.000

Alternative Cloud: Per Chi Non Vuole Comprare Hardware

Se preferisci non investire in hardware o hai bisogno di scalabilità on-demand, esistono ottimi provider cloud specializzati in GPU per AI. Ecco i migliori nel 2026:

RunPod – Il Più Flessibile

- GPU disponibili: RTX 4090, A100, H100, MI300X

- Prezzi: da $0.34/ora (RTX 4090) a $1.99/ora (H100)

- Caratteristiche: billing al secondo, cold start sotto 200ms, serverless

- Sito: runpod.io

Lambda Labs – Per Training Serio

- GPU disponibili: H100, H200 con InfiniBand

- Prezzi: da $1.10/ora (A100) a $2.49/ora (H100)

- Caratteristiche: zero egress fees, cluster 1-click, sconto 50% accademici

- Sito: lambda.ai

Vast.ai – Il Più Economico

- GPU disponibili: marketplace decentralizzato, RTX 3090 da $0.20/ora

- Prezzi: i più bassi del mercato, ma qualità variabile

- Caratteristiche: ideale per esperimenti e budget limitati

- Sito: vast.ai

Hyperstack – Enterprise Grade

- GPU disponibili: H100, A100, L40 con NVLink

- Prezzi: competitivi con SLA enterprise

- Caratteristiche: AI Studio no-code, VM hibernation, GDPR compliant

- Sito: hyperstack.cloud

Nebius AI Cloud – Made in EU

- GPU disponibili: H100 da $2.00/ora

- Prezzi: sconti fino al 35% per uso continuativo

- Caratteristiche: data center in Finlandia e Parigi, NVIDIA Preferred Partner

- Sito: nebius.ai

Il Nostro Servizio: Assistenza e Installazione Hardware AI

Acquistare una workstation AI è solo il primo passo. Configurarla correttamente, installare i driver CUDA, ottimizzare i framework e far funzionare tutto in armonia richiede competenze specifiche.

Offriamo servizi completi di assistenza per hardware AI:

- Consulenza pre-acquisto: ti aiutiamo a scegliere la configurazione giusta per i tuoi casi d'uso

- Installazione e configurazione: setup completo di driver, CUDA, cuDNN, framework AI

- Ottimizzazione: tuning delle performance per i modelli che utilizzi

- Formazione: training per il tuo team sull'utilizzo della workstation

- Supporto continuativo: assistenza tecnica per problemi e aggiornamenti

Che tu scelga un NVIDIA DGX Spark, una workstation BIZON o un sistema custom, possiamo supportarti in ogni fase. Richiedi un preventivo personalizzato per il nostro servizio di assistenza hardware AI.

Leggi anche

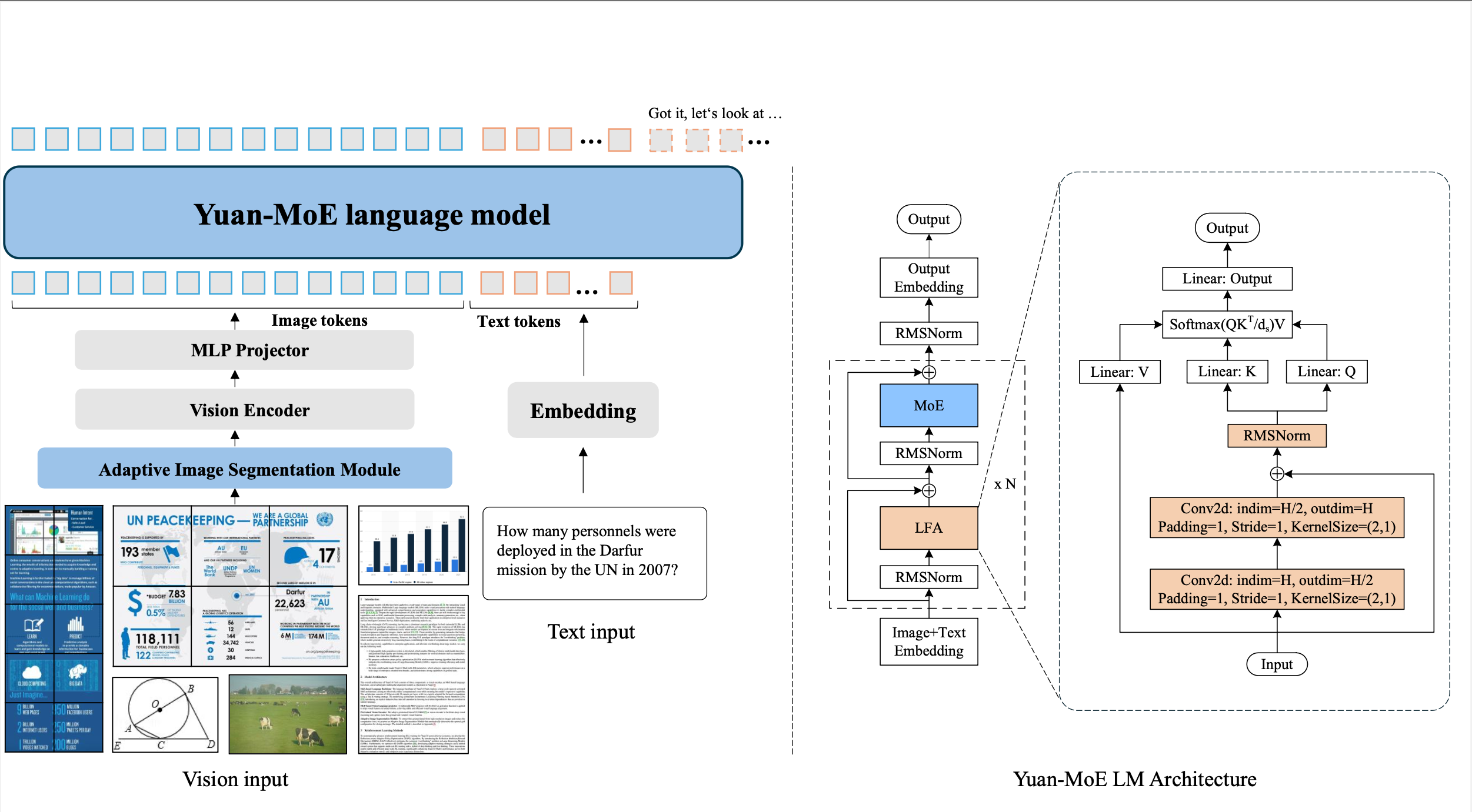

- Yuan 3.0 Flash: Guida Completa al Modello LLM per Aziende

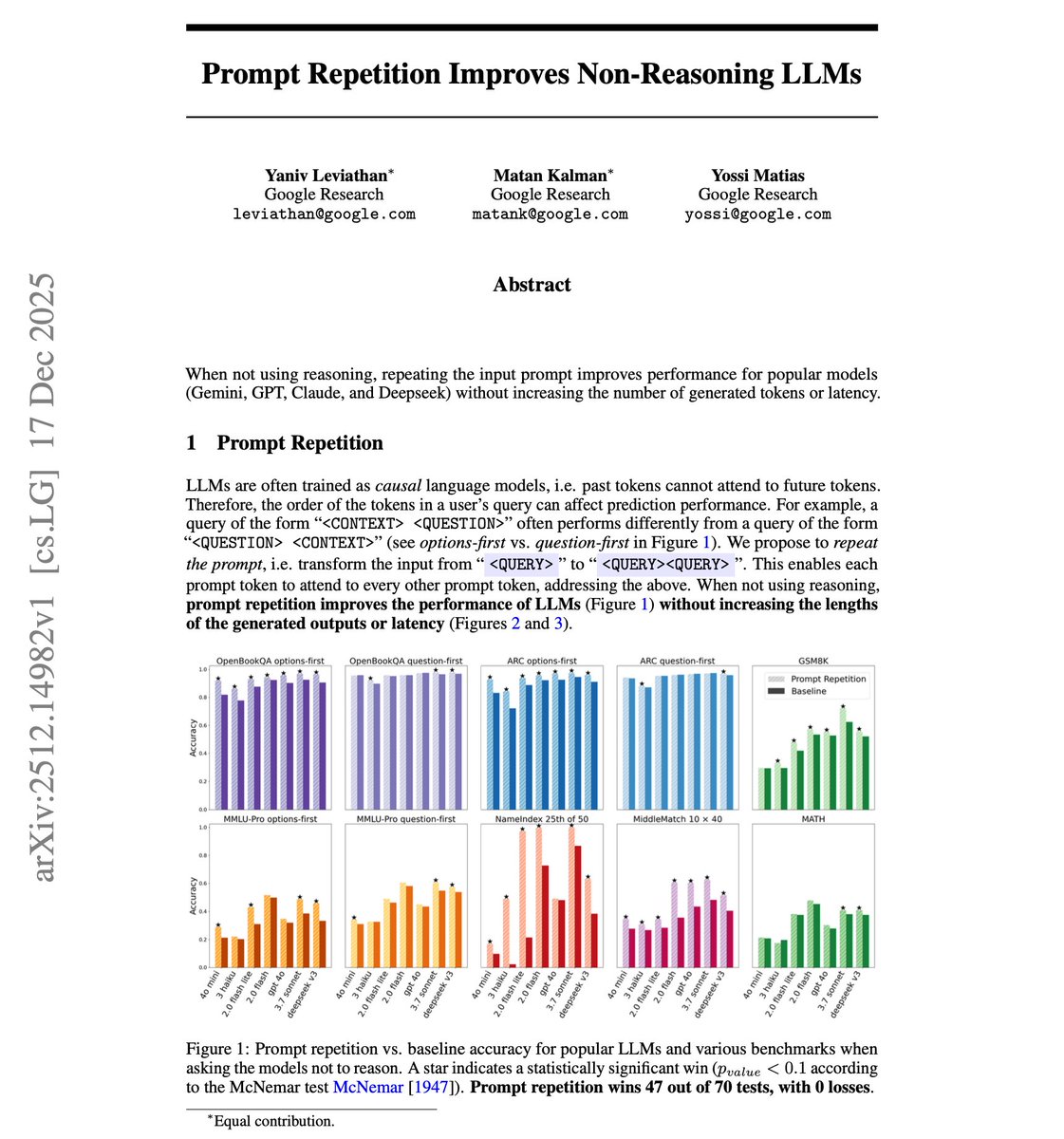

- Prompt Repetition: La Tecnica Semplice che Migliora gli LLM

- Microsoft Copilot Studio per VS Code: Agenti AI Come Codice

- Claude Cowork: Automazione Desktop con Intelligenza Artificiale

Conclusioni: Quale PC AI Scegliere?

La scelta dipende dal tuo budget e dai modelli che vuoi eseguire:

- Budget sotto €2.000: workstation con RTX 3090 usata, ideale per iniziare

- Budget €3.500-5.000: DGX Spark o custom RTX 5090, ottimo equilibrio

- Budget €10.000+: BIZON G3000 multi-GPU per training serio

- Budget illimitato: DGX Station per modelli frontier da 1 trilione di parametri

- Nessun hardware: RunPod o Lambda Labs per pay-as-you-go

L'intelligenza artificiale locale non è più fantascienza: è una realtà accessibile. Se vuoi portare l'AI nella tua azienda con hardware dedicato e hai bisogno di supporto professionale, contattami per una consulenza. Insieme possiamo identificare la soluzione migliore e configurarla per le tue esigenze specifiche.